Durante años, el ransomware fue presentado como una amenaza relativamente simple. Un virus que bloqueaba la pantalla de una computadora y exigía un pago para devolver el acceso a los archivos. El escenario era casi siempre el mismo: un mensaje alarmante, una cuenta de criptomonedas y la promesa de que, si pagabas, todo volvería a la normalidad.

Esa imagen se volvió tan familiar que muchas personas creen que el ransomware sigue funcionando de esa manera. Sin embargo, la realidad cambió hace tiempo. Lo que hoy conocemos como ransomware ya no es solo un programa que cifra documentos, y entender cómo proteger esa información —por ejemplo, eligiendo adecuadamente entre los mejores software de copias de seguridad— se volvió una decisión estratégica. Se ha convertido en una operación criminal organizada, con grupos que investigan a sus víctimas, se infiltran silenciosamente en sus redes y preparan ataques con una lógica mucho más estratégica.

En muchos casos, cuando el mensaje de rescate finalmente aparece en la pantalla, el ataque en realidad comenzó semanas antes.

Cuando el objetivo deja de ser el computador

Durante la primera etapa del ransomware, el mecanismo era relativamente directo: bloquear archivos para obligar a la víctima a pagar por su recuperación. Mientras las organizaciones no tenían copias de seguridad confiables, ese modelo funcionó durante años.

Pero algo cambió cuando las empresas empezaron a implementar políticas de respaldo más robustas. Si una compañía podía restaurar sus datos desde un backup reciente, el atacante perdía su principal herramienta de presión.

La respuesta fue tan simple como inquietante.

Antes de cifrar los archivos, ahora los atacantes los copian.

Los grupos de ransomware modernos suelen infiltrarse en una red corporativa o en una computadora personal y permanecer allí durante días o incluso semanas sin ser detectados, mostrando a veces indicios sutiles de actividad anómala similares a los descritos en esta guía sobre señales de que un dispositivo podría estar comprometido. Durante ese tiempo exploran servidores, carpetas compartidas, correos electrónicos y sistemas internos en busca de información valiosa. Documentos fiscales, bases de datos de clientes, contratos o archivos internos pueden convertirse en instrumentos de presión.

Cuando finalmente ejecutan el ataque, el mensaje ya no se limita a exigir dinero para recuperar archivos. La amenaza ahora incluye algo mucho más delicado: si no pagas, la información se publica.

Ese cambio transformó el ransomware en algo mucho más cercano a la extorsión digital que a un simple virus informático.

La ilusión de seguridad de los backups

Durante mucho tiempo se pensó que las copias de seguridad eran la respuesta definitiva al ransomware. Y en cierto modo lo fueron, pero solo mientras los ataques se limitaban a cifrar archivos.

Hoy la situación es diferente.

Muchos usuarios mantienen respaldos en discos externos conectados permanentemente a sus computadoras o en sistemas de almacenamiento accesibles desde la red. En el caso de sitios web, especialmente WordPress, es fundamental ir más allá de soluciones improvisadas y aplicar buenas prácticas como las que detallamos en esta guía sobre copias de seguridad en WordPress. Otros confían en carpetas sincronizadas con servicios en la nube que replican automáticamente los archivos.

El problema es que el ransomware moderno está diseñado precisamente para encontrar esos recursos.

Cuando el malware detecta unidades conectadas o repositorios accesibles desde la red, esos archivos suelen terminar cifrados también. Y si la información ya fue copiada por los atacantes antes del cifrado, restaurar un backup no necesariamente resuelve el problema.

La información ya salió del sistema.

Por eso, en seguridad informática se insiste cada vez más en un principio que puede parecer antiguo, pero sigue siendo esencial: al menos una copia de los datos debe existir fuera de la red principal, en un entorno que no pueda ser alcanzado por el mismo ataque que compromete los sistemas operativos o los servidores internos.

Un ataque que muchas veces llega en silencio

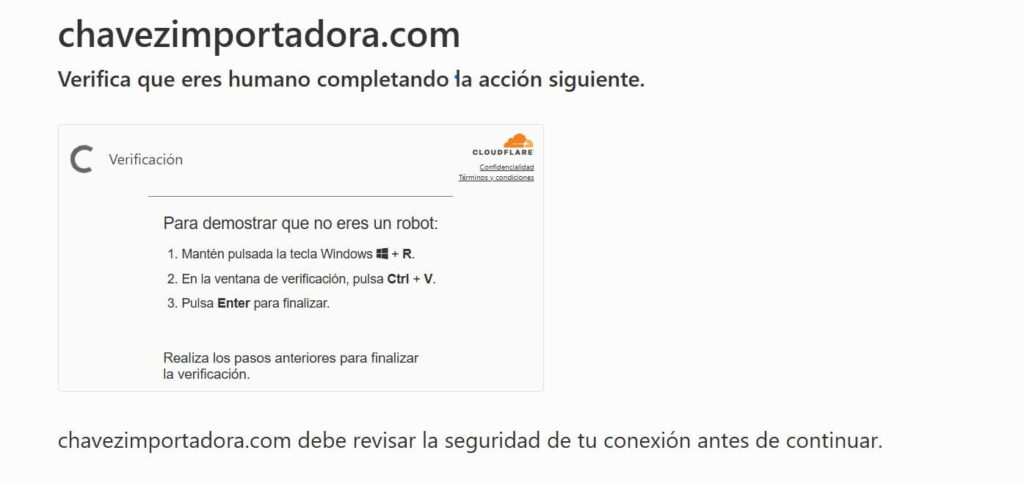

Durante años se repitió una recomendación sencilla: no abrir correos sospechosos ni hacer clic en enlaces desconocidos. Aunque sigue siendo un buen consejo, hoy resulta insuficiente para explicar cómo se producen muchos ataques.

Una parte importante del malware actual se distribuye a través de publicidad maliciosa, sitios web comprometidos o extensiones de navegador que han sido modificadas después de años de uso legítimo. En otros casos, los atacantes compran accesos iniciales obtenidos previamente por otros grupos criminales.

Esto significa que el ataque no siempre comienza con un error evidente del usuario. A veces basta con una vulnerabilidad sin parchear o con un servicio expuesto a Internet que tenga una configuración débil.

El punto de entrada puede ser silencioso y permanecer oculto durante días.

Cuando el problema deja de ser técnico

Quizá el aspecto más complejo del ransomware moderno no es el malware en sí, sino el impacto que puede tener sobre la operación de una empresa.

Muchas organizaciones todavía ven la seguridad informática como un asunto exclusivo del área de sistemas. Sin embargo, cuando los sistemas que gestionan facturación, clientes, inventarios o comunicaciones internas dejan de funcionar, el problema deja de ser técnico y se convierte en un problema operativo.

Y cuando la información además ha sido robada, el impacto puede extenderse al ámbito reputacional o incluso legal.

Por eso cada vez más empresas están entendiendo que la conversación ya no gira únicamente alrededor de antivirus o firewalls. La verdadera discusión es cómo garantizar que el negocio pueda seguir operando incluso después de un incidente.

Algunas medidas básicas que ayudan a reducir el riesgo

Aunque ningún sistema puede eliminar completamente el riesgo de ransomware, sí existen prácticas relativamente simples que reducen significativamente el impacto de un ataque.

Una de las más importantes es mantener copias de seguridad en más de un lugar, idealmente con al menos una versión que no esté conectada permanentemente a la red. También resulta recomendable mantener los sistemas actualizados, limitar los accesos innecesarios a servidores y separar los servicios más críticos para evitar que un incidente afecte a toda la operación.

Muchas pequeñas empresas comienzan aplicando estas medidas de forma gradual, utilizando discos externos para respaldos periódicos o servicios de almacenamiento en la nube para duplicar información importante.

Estas prácticas no eliminan el riesgo, pero sí crean una primera línea de defensa frente a incidentes que pueden paralizar una operación.

Cuando las empresas necesitan algo más robusto

A medida que una empresa crece y depende cada vez más de sistemas digitales, estas soluciones básicas suelen quedarse cortas. Restaurar manualmente datos desde múltiples discos o gestionar respaldos dispersos puede convertirse en un proceso lento y riesgoso justo cuando el tiempo es más crítico.

Por esa razón, muchas organizaciones empiezan a adoptar infraestructuras diseñadas específicamente para resiliencia. Plataformas donde los datos se protegen mediante snapshots automáticos, almacenamiento redundante y copias externas que permanecen aisladas de la red principal.

En estos entornos, la información puede recuperarse rápidamente incluso si un servidor completo se ve comprometido.

Algunos proveedores especializados en infraestructura empresarial han comenzado a ofrecer este tipo de arquitectura como servicio. Por ejemplo, entornos de nube privada con snapshots periódicos, almacenamiento empresarial para copias de respaldo externas o sistemas que separan los servicios críticos —como correo, aplicaciones o almacenamiento— para evitar que un incidente afecte a todo el entorno.

Servicios como los que ofrece Nettix están orientados precisamente a ese tipo de enfoque. Infraestructuras donde los datos no dependen de un único sistema y donde las copias de seguridad forman parte de la arquitectura misma, en lugar de ser un proceso improvisado.

La pregunta que muchas empresas evitan hacerse

Al final, el ransomware moderno obliga a replantear una pregunta incómoda.

No se trata solo de saber si existe un antivirus instalado o una carpeta llamada “backup”. La pregunta real es mucho más directa.

Si mañana tus datos desaparecen, o si alguien amenaza con publicar la información interna de tu empresa, ¿qué tan preparada está tu organización para continuar operando?

En una economía donde casi todos los procesos dependen de sistemas digitales, la infraestructura dejó de ser un detalle técnico. Se convirtió en una pieza central de la resiliencia de cualquier negocio.

Y cuanto antes se diseñe pensando en ese escenario, menor será el costo cuando algo inevitablemente falle. Parte de ese diseño incluye permitir que el propio sistema se mantenga protegido mediante actualizaciones automáticas, como explicamos en https://www.sciwebhosting.com/seguridad/actualizaciones-automaticas-por-que-activarlas/.